Ça y est, votre projet est sorti. Après plusieurs semaines ou plusieurs mois de travaux acharnés, votre nouveau site, votre application ouvre enfin ses portes à son public. C’est certain, après tous ces efforts et attentions conjugués, les nombreux experts impliqués dans la conception et la réalisation, le succès ne peut être qu’au rendez-vous. On peut enfin laisser le cours des choses se dérouler tranquillement, après tout, le chantier est terminé, advienne que pourra…

Vraiment ?

Pas tout à fait, car vous possédez un grand pouvoir… et de grandes responsabilités ;)

Car, si un artiste ne peut que constater le succès ou l’échec de son oeuvre, vous avez en revanche la capacité (et le devoir) de répondre aux attentes de vos utilisateurs.

C’est votre plus grand malheur et en même temps, votre plus grande chance : en matière de projets digitaux, rien n’est définitivement gravé dans le marbre. Vous pouvez encore ajuster votre projet pour qu’il réponde encore mieux à la demande.

Comment savoir si mon projet est un succès ou non ?

Sauf si vos raisons étaient fondamentalement mauvaises, vous vous êtes fixé, en le sachant ou non, des objectifs : vendre plus de produits ou les vendre mieux, faire connaître vos produits ou vos services, gagner des fans sur vos réseaux sociaux, améliorer votre image, etc…

Ces objectifs sont fondamentaux car ils vont poser les bases des analyses qui vous permettront d’évaluer l’adéquation de votre projet vis-à-vis de l’attente de vos utilisateurs et de vos clients.

OK, j’ai des objectifs clairs, mais après ?

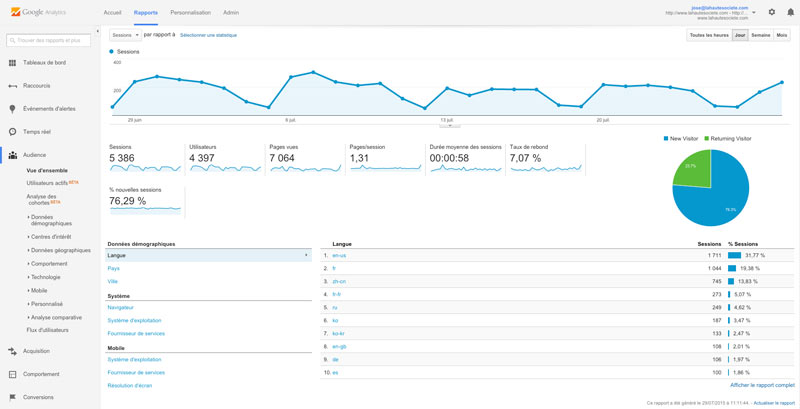

A minima, une fois le projet en ligne, vous avez rapidement à votre disposition des informations techniques de base : combien de connexions à votre site, nombre de téléchargements de votre application, les pages consultées, l’origine et l’équipement de vos visiteurs…

Votre hébergeur peut vous fournir ces informations de base, mais l’intégration d’une solution telle que Google Analytics peut vous aider à obtenir des informations compréhensibles beaucoup plus facilement et précisément.

L’interface de Google Analytics : du fun à tous les étages.

En y ajoutant les éventuels outils de mesure mis à disposition dans vos outils d’administration, l’ensemble donne les premières informations permettant d’analyser l’atteinte des objectifs initiaux (articles lus ou non, quantité d’abonnement à la newsletter, chiffre d’affaires rapporté par la vente en ligne produit par produit…).

Très bien, j’ai analysé, mais j’en fais quoi ?

Que vos objectifs soient atteints ou pas, les leviers d’améliorations vont rapidement apparaître. On peut toujours faire mieux, rappelez vous que rien n’est définitif.

La première étape importante consiste à faire un inventaire complet des axes d’évolutions possibles puis, si plusieurs axes émergent, d’établir des priorités en terme d’impact sur les objectifs.

Mais comment savoir ce qu’attendent mes utilisateurs, comment faire pour les mener là ou je le souhaite ?

Évidemment, surtout si vous travaillez en équipe, chacun aura un avis sur les solutions à mettre en place. Le dernier mot revient souvent au plus haut placé, ce qui peut parfois conduire à de mauvais choix.

Il va falloir trouver un moyen de valider ces intuitions. C’est la qu’entre en jeu un outil imparable : les tests A/B.

Les tests A/B, kezako ?

Derrière ce terme barbare se cache une idée toute simple : quand vous ne savez pas quelle solution choisir, laissez vos clients trancher pour vous.

Évidement, il va falloir les aider un peu en leur présentant différentes versions (au moins 2, le A et le B dans “tests A/B”) afin d’évaluer celle à laquelle ils réagissent le mieux en fonction de vos objectifs.

Pour simplifier, le test A/B permet de valider une hypothèse résultante de vos analyses préalables. Par exemple, “si le bouton de mise au panier (call to action pour les intimes) sur ma fiche produit était rouge au lieu d’être gris, il y aurait plus de chance d’être cliqué” ou “si je change le titre de mon article, celui-ci sera plus consulté” ou “si j’adopte une présentation différente de mes produits sur ma page d’accueil, mes nouveaux visiteurs voudront en savoir plus”…

Une fois ces variantes établies et le test démarré, pendant une durée donnée, elles seront affichées à vos visiteurs/utilisateurs de manière équitable : 50% verront toujours la version A et les autres 50%, la version B. Le fait de conduire le test de façon simultané permet d’analyser leur comportement de manière fiable.

C’est bien beau tout ça, mais concrètement, on s’y prend comment ?

Il existe de nombreux outils conçus pour gérer ce genre de tests. Pour ne citer que les plus populaires :

- Google Analytics Content Experiments (anciennement Google Site Optimizer)

- Optimizely

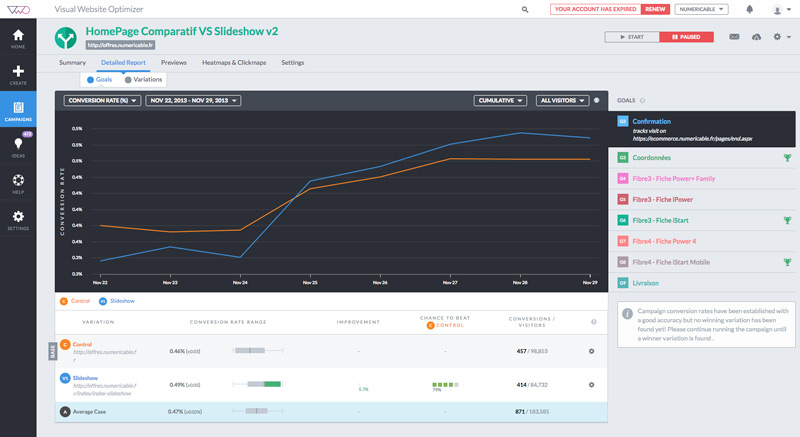

- Visual Website Optimizer

Ces outils sont des solutions à (faire) intégrer dans votre projet sous forme de librairie javascript pour les sites web (similaire à un tag Google Analytics) ou un composant logiciel spécialisé pour les applications mobiles. Celles-ci sont plus ou moins simples à mettre en place en fonction de la complexité du projet, mais une fois mise en place, vous pouvez conduire autant de tests que vous le souhaitez.

C’est parti pour des tests endiablés dans une ambiance de folie !

Vous disposez dès lors d’une relative liberté pour concevoir vos versions alternatives. Changer la couleur d’un bouton, le texte d’une accroche, le visuel d’une bannière représentent des opérations assez simples à mettre en place, 10 minutes suffisent pour lancer un premier test. Si vous souhaiter tester des modifications plus structurantes comme un contenu alternatif complètement différent, il faudra alors concevoir, développer et mettre en ligne celle-ci avant de pouvoir déclencher les tests.

Avant de vous lancer, il faut également calculer le temps et le nombre nécessaires de visiteurs afin d’obtenir des résultats pertinents. Des outils de calculs sont mis à disposition afin de vous aider à déterminer précisément ces données. Il résulterait d’un test trop court ou avec trop peu de trafic des conclusions erronées. Généralement, environ 3 semaines de tests sont nécessaires afin de s’assurer qu’aucune circonstance conjoncturelle ne vient polluer les résultats.

Comme indiqué précédemment, il est essentiel qu’un ou plusieurs objectifs soient fixés afin de qualifier les résultats attendus : visite d’une certaine page, clic sur un bouton précis, inscription à une newsletter, abonnement à un réseau social…

Comme tout dispositif d’analyse, l’AB/testing a ses limites, comme le rappelle à juste titre cet article de Mathieu Tranvan

Celui par qui tout est arrivé: le fameux abbé Testing (de son vrai nom Albanus Jubertus). Un document exceptionnel de 1892, que nous sommes fiers de vous dévoiler en exclusivité.

Le test est terminé, je ne suis que joie.

Voila, les chiffrent tombent, sans appel. L’une ou l’autre version prouve qu’elle est plus efficace… et pas forcément celle sur laquelle vous aviez misé !

Il ne reste plus qu’à valider définitivement la version alternative, ou maintenir l’existante si elle se révèle être la “gagnante”.

N’oubliez pas de diffuser les résultats aux équipes intéressées : designers, marketing, développeurs…

Maintenant, vous pouvez passer au test suivant.

Quelques conseils pour conclure

- Gardez à l’esprit que les tests A/B ne vous disent jamais ce qu’il faut tester. C’est à vous de le déterminer.

- Toujours partir d’une analyse et de faits concrets avant de se lancer dans un test. Il n’y a rien de moins efficace que de tester “à l’aveugle” ou sur une seule intuition.

- Toujours fixer des objectifs clairs et précis et au moins un majeur.

- Ne pas partir avec des à priori sur les résultats attendus. Vous pouvez vous tromper et être surpris.

- Ne pas arrêter les tests trop tôt surtout sous prétexte que les résultats vont dans votre sens.

- Ne pas laisser les tests courir pour toujours non plus…

- Limiter les variations à des ensembles permettant l’analyse.

- Toujours tester les variantes de manière simultané sur un échantillon équivalent d’utilisateurs pour les différentes versions.

- Réaliser des tests réguliers.